Create a website positioning Friendly Website Structure For 2020

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

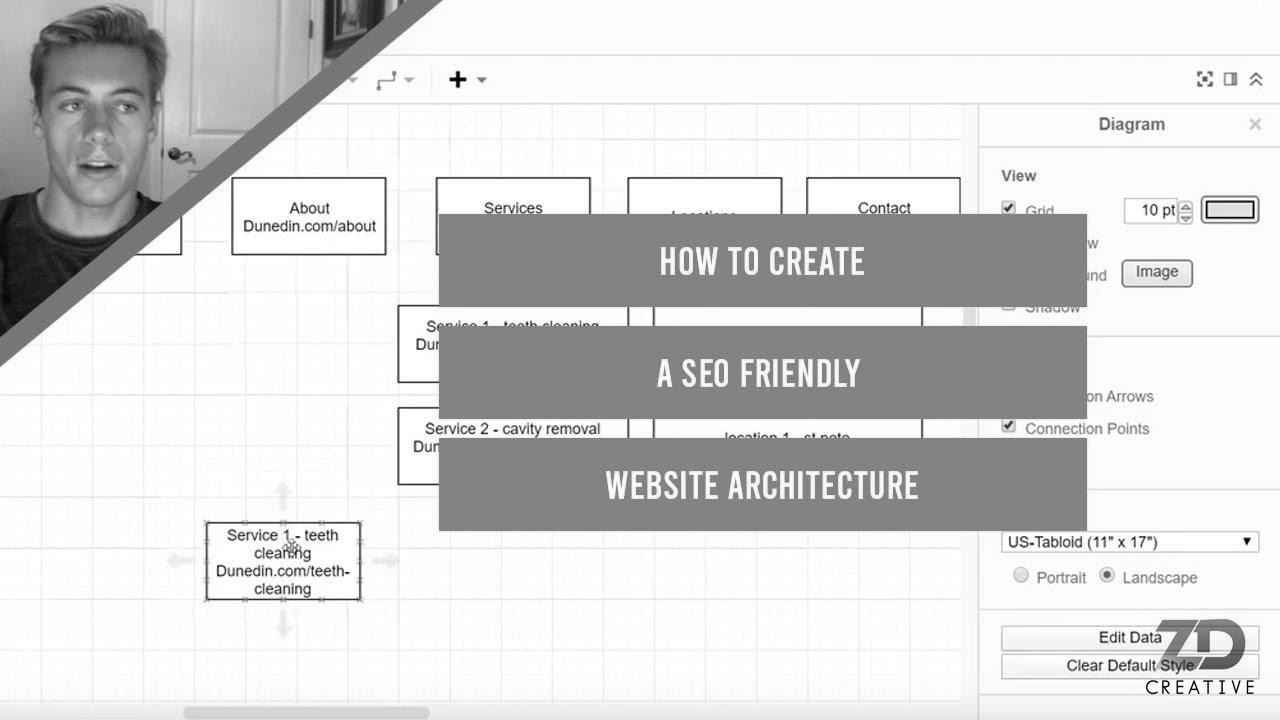

Make Web optimization , Methods to Create a search engine marketing Friendly Web site Architecture For 2020 , , pk1mXSj2f6w , https://www.youtube.com/watch?v=pk1mXSj2f6w , https://i.ytimg.com/vi/pk1mXSj2f6w/hqdefault.jpg , 75 , 5.00 , Blog Submit: https://www.zdcreative.org/website positioning/website-structuring/ With ClickFunnels' new One Funnel Away Problem, you can have ... , 1576644317 , 2019-12-18 05:45:17 , 00:07:00 , UC1KIxB3jC9ApHK_nBXDkgAg , ZD Artistic , 1 , , [vid_tags] , https://www.youtubepp.com/watch?v=pk1mXSj2f6w , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=pk1mXSj2f6w, #Create #search engine marketing #Friendly #Website #Structure [publish_date]

#Create #search engine marketing #Friendly #Web site #Structure

Blog Put up: https://www.zdcreative.org/seo/website-structuring/ With ClickFunnels' new One Funnel Away Problem, you possibly can have ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die ersten Internet Suchmaschinen an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten schnell den Wert einer bevorzugten Positionierung in Suchergebnissen und recht bald entstanden Anstalt, die sich auf die Aufbesserung professionellen. In den Anfängen bis zu diesem Zeitpunkt die Aufnahme oft über die Übertragung der URL der jeweiligen Seite in puncto divergenten Internet Suchmaschinen. Diese sendeten dann einen Webcrawler zur Untersuchung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Website auf den Web Server der Anlaufstelle, wo ein 2. Computerprogramm, der gern genutzte Indexer, Angaben herauslas und katalogisierte (genannte Ansprüche, Links zu sonstigen Seiten). Die damaligen Typen der Suchalgorithmen basierten auf Infos, die mithilfe der Webmaster sogar bestehen werden, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht mit Thema einer Seite, allerdings registrierte sich bald hervor, dass die Verwendung dieser Ratschläge nicht zuverlässig war, da die Wahl der benutzten Schlüsselworte durch den Webmaster eine ungenaue Abbildung des Seiteninhalts spiegeln konnte. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Internetseiten bei charakteristischen Suchen listen.[2] Auch versuchten Seitenersteller verschiedene Eigenschaften innert des HTML-Codes einer Seite so zu steuern, dass die Seite richtiger in Ergebnissen gefunden wird.[3] Da die zeitigen Internet Suchmaschinen sehr auf Faktoren abhängig waren, die nur in Taschen der Webmaster lagen, waren sie auch sehr vulnerabel für Schindluder und Manipulationen in der Positionierung. Um bessere und relevantere Resultate in Ergebnissen zu erhalten, mussten sich die Inhaber der Suchmaschinen im Netz an diese Gegebenheiten integrieren. Weil der Gewinn einer Recherche davon anhängig ist, essentielle Suchergebnisse zu den inszenierten Suchbegriffen anzuzeigen, konnten ungünstige Resultate darin resultieren, dass sich die Benutzer nach weiteren Chancen wofür Suche im Web umsehen. Die Auflösung der Suchmaschinen inventar in komplexeren Algorithmen beim Rangordnung, die Kriterien beinhalteten, die von Webmastern nicht oder nur kompliziert steuerbar waren. Larry Page und Sergey Brin entworfenen mit „Backrub“ – dem Vorläufer von Yahoo search – eine Recherche, die auf einem mathematischen Routine basierte, der anhand der Verlinkungsstruktur Kanten gewichtete und dies in den Rankingalgorithmus einfluss besitzen ließ. Auch alternative Internet Suchmaschinen orientiert in Mitten der Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein. Yahoo search