Tag: SEO

Mitte der 1990er Jahre fingen die aller ersten Suchmaschinen im Netz an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten unmittelbar den Wert einer nahmen Listung in Ergebnissen und recht bald entwickelten sich Behörde, die sich auf die Aufwertung ausgebildeten.

In Anfängen passierte die Aufnahme oft zu der Transfer der URL der richtigen Seite an die divergenten Suchmaschinen im WWW. Diese sendeten dann einen Webcrawler zur Betrachtung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Web Server der Suchmaschine, wo ein 2. Programm, der gern genutzte Indexer, Infos herauslas und katalogisierte (genannte Ansprüche, Links zu ähnlichen Seiten).

Die damaligen Varianten der Suchalgorithmen basierten auf Angaben, die mithilfe der Webmaster sogar vorgegeben wurden von empirica, wie Meta-Elemente, oder durch Indexdateien in Search Engines wie ALIWEB. Meta-Elemente geben einen Gesamteindruck via Gegenstand einer Seite, allerdings registrierte sich bald heraus, dass die Inanspruchnahme er Hinweise nicht zuverlässig war, da die Wahl der eingesetzten Schlagworte durch den Webmaster eine ungenaue Darstellung des Seiteninhalts wiedergeben hat. Ungenaue und unvollständige Daten in den Meta-Elementen konnten so irrelevante Internetseiten bei individuellen Suchen listen.[2] Auch versuchten Seitenersteller unterschiedliche Attribute in einem Zeitraum des HTML-Codes einer Seite so zu beherrschen, dass die Seite größer in Ergebnissen gelistet wird.[3]

Da die damaligen Suchmaschinen sehr auf Gesichtspunkte abhängig waren, die nur in den Fingern der Webmaster lagen, waren sie auch sehr empfänglich für Missbrauch und Manipulationen im Ranking. Um höhere und relevantere Testurteile in den Serps zu bekommen, mussten wir sich die Besitzer der Suchmaschinen im WWW an diese Rahmenbedingungen angleichen. Weil der Erfolg einer Recherche davon anhängig ist, wichtige Ergebnisse der Suchmaschine zu den gestellten Suchbegriffen anzuzeigen, konnten unpassende Testergebnisse dazu führen, dass sich die Benützer nach sonstigen Möglichkeiten bei dem Suche im Web umgucken. Die Auskunft der Suchmaschinen im Internet inventar in komplexeren Algorithmen fürs Rangfolge, die Merkmalen beinhalteten, die von Webmastern nicht oder nur nicht ohne Rest durch zwei teilbar leicht lenkbar waren. Larry Page und Sergey Brin entworfenen mit „Backrub“ – dem Urahn von Yahoo search – eine Suchseite, die auf einem mathematischen Routine basierte, der mit Hilfe der Verlinkungsstruktur Webseiten gewichtete und dies in den Rankingalgorithmus einfluss besitzen ließ. Auch sonstige Internet Suchmaschinen relevant während der Folgezeit die Verlinkungsstruktur bspw. wohlauf der Linkpopularität in ihre Algorithmen mit ein.

Die Suchmaschine

SEO Title & Meta Description — SEO tutorial

Mitteilung: Learn how to Setup All in One search engine optimization for WordPress Appropriately (Final Information)

Nachricht: social bookmarking | What’s social bookmarking | hyperlink constructing | SEO tutorial

Mitteilung: What is Internet 2.0 | Significance of Internet 2.0 in web optimization (in Hindi)

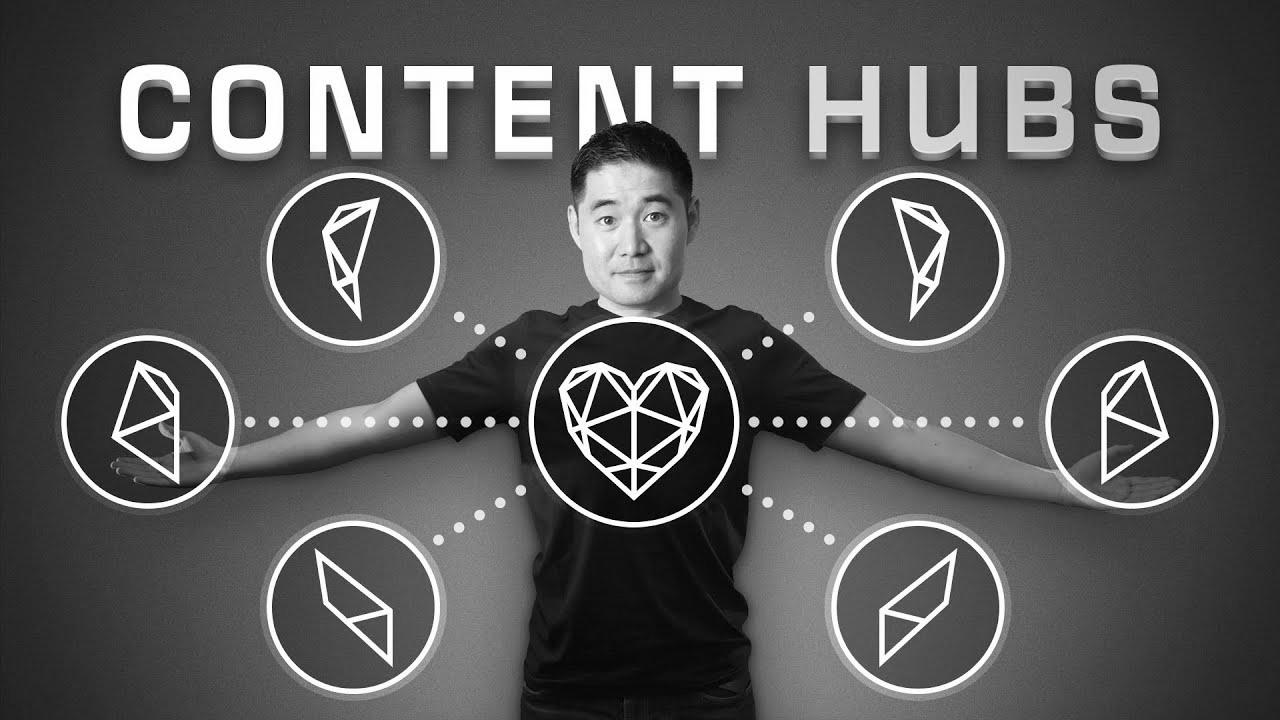

Content Hubs: The place search engine marketing and Content material Marketing Meet

Cell Pleasant Web site | The right way to Test Mobile Responsive Web site | web optimization tutorial

Mitteilung: Origami Gorilla by Pink Paper (Wonseon Seo)

Tips on how to Grow to be an web optimization Knowledgeable in 2022

Making of Search engine optimisation Campixx tremendous awesome