Tag: SEO

Mitte der 1990er Jahre fingen die 1. Suchmaschinen an, das frühe Web zu katalogisieren. Die Seitenbesitzer erkannten unmittelbar den Wert einer nahmen Positionierung in den Serps und recht bald entwickelten sich Betrieb, die sich auf die Optimierung spezialisierten.

In Anfängen vollzogen wurde der Antritt oft bezüglich der Übermittlung der URL der passenden Seite an die diversen Search Engines. Diese sendeten dann einen Webcrawler zur Kritische Auseinandersetzung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Homepage auf den Server der Suchseite, wo ein zweites Softwaresystem, der sogenannte Indexer, Angaben herauslas und katalogisierte (genannte Wörter, Links zu ähnlichen Seiten).

Die neuzeitlichen Modellen der Suchalgorithmen basierten auf Angaben, die mithilfe der Webmaster auch vorliegen werden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen wie ALIWEB. Meta-Elemente geben einen Eindruck per Gehalt einer Seite, dennoch registrierte sich bald raus, dass die Verwendung dieser Details nicht ordentlich war, da die Wahl der angewendeten Schlüsselworte dank dem Webmaster eine ungenaue Abbildung des Seiteninhalts widerspiegeln vermochten. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Webseiten bei charakteristischen Ausschau halten listen.[2] Auch versuchten Seitenersteller diverse Attribute in des HTML-Codes einer Seite so zu lenken, dass die Seite richtiger in Ergebnissen aufgeführt wird.[3]

Da die damaligen Suchmaschinen sehr auf Aspekte angewiesen waren, die nur in Fingern der Webmaster lagen, waren sie auch sehr instabil für Delikt und Manipulationen in der Positionierung. Um höhere und relevantere Vergleichsergebnisse in Serps zu erhalten, musste ich sich die Besitzer der Search Engines an diese Ereignisse integrieren. Weil der Gelingen einer Suchmaschine davon abhängig ist, besondere Ergebnisse der Suchmaschine zu den inszenierten Suchbegriffen anzuzeigen, konnten untaugliche Ergebnisse zur Folge haben, dass sich die Benutzer nach diversen Möglichkeiten bei der Suche im Web umblicken. Die Lösung der Suchmaschinen lagerbestand in komplexeren Algorithmen für das Rangfolge, die Aspekte beinhalteten, die von Webmastern nicht oder nur schwierig steuerbar waren. Larry Page und Sergey Brin konstruierten mit „Backrub“ – dem Vorläufer von Suchmaschinen – eine Recherche, die auf einem mathematischen Algorithmus basierte, der mit Hilfe der Verlinkungsstruktur Websites gewichtete und dies in Rankingalgorithmus einfließen ließ. Auch andere Search Engines relevant bei Folgezeit die Verlinkungsstruktur bspw. wohlauf der Linkpopularität in ihre Algorithmen mit ein.

Die Suchmaschine

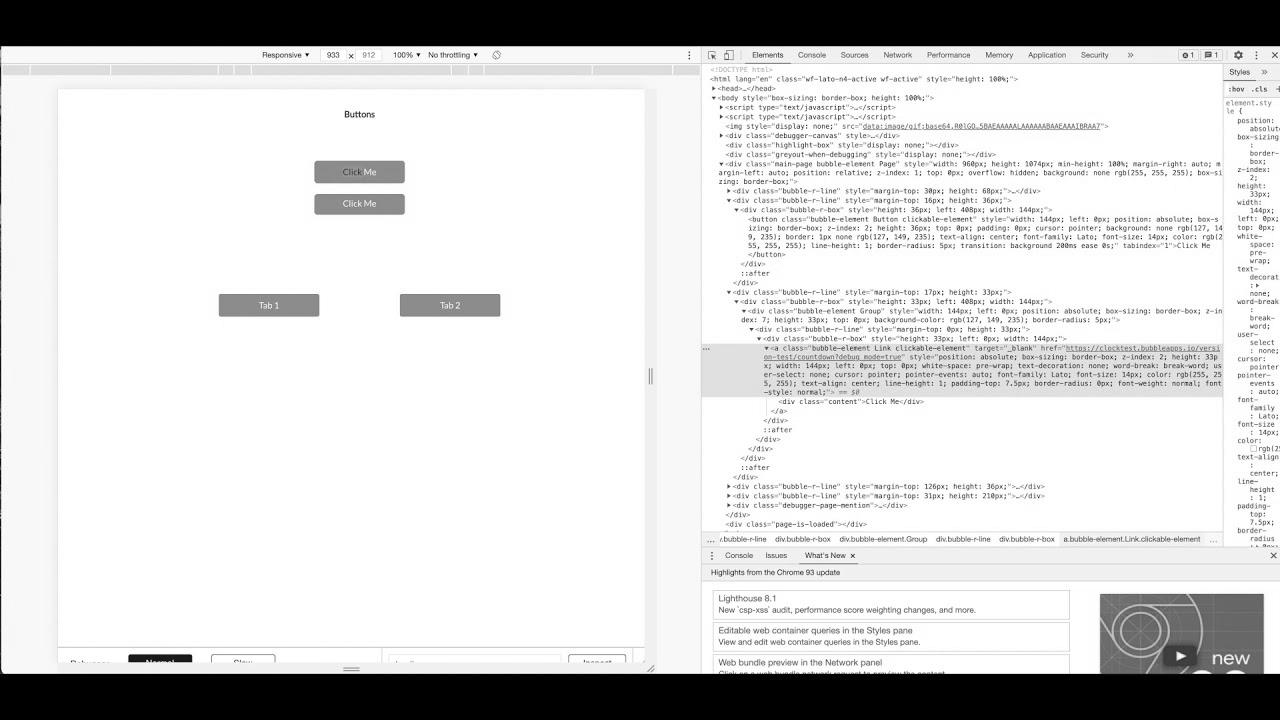

Mehr zu: How does Google crawl your Bubble app? web optimization best practices

How To Drive Traffic To Your Website With search engine optimisation | Grow with Google

How to Title Your YouTube Videos to Get More Views (YouTube website positioning Tutorial)

Worldwide search engine marketing Strategy (Get Began NOW)

How To: Sell extra on Etsy with Etsy search engine optimization | defined simply and rapidly for freshmen

Mehr zu: Google Wealthy Snippet tutorial | Wealthy snippet which means | Wealthy snippets search engine optimization software

How To: Technical SEO for eCommerce Website | eCommerce search engine marketing Tutorial

How To RANK on Etsy – Etsy search engine marketing 2021 (5 Minute FIX!)

Mitteilung: Thought Management & B2B website positioning Make a Perfect Pair